フォーラムへの返信

-

投稿者投稿

-

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスターぽうざマスターさん、

こんにちは。

試したことがないので確証はないのですが、可能性があるとするとFlatからFlatDarkを引くプロセスのような気がします。下記のフローを見ていただきたいのですが、FlatDarkによるFlatのCalibrationはスタック済みのFlatではなく、Subframeの1枚ずつに実行しCalibartionされたFlatを作り、その後にIntegrationしてMasterFlatを生成します。

https://masahiko.me/wbpp20-pixinsight/

1200枚のFlatのSubframeをいったんFlatDarkでCalibrationしてCalibration済みのFlatのSubframeを1200枚作り、その後に300枚ずつIntegrationし、最後にまとめてIntegrationしたらどんな結果になるでしょうか。

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスターおお、よかったです。

「 システム内のインデックスが見えづらいところに隠れていた」とはどんな意味でしたか?

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスター白石さん

こんにちは。

ネットで情報を調べたところ、同じようにWBPPが起動しなくなる問題が起きた方は何人かいらっしゃいました。皆さんとも、いったん現在のPixInsightをアンインストールしてもう一度、PixInsightをインストールしなおすと、WBPPが起動するようになっていました。

お手数とは思いますが、試してくださいますか。

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスターToshy-jiGさん

はい、Debayerしないdrizzle(いわゆるbayer drizzle)です。このことはWBPPのログを解析して確認しました。また結果もdebayerの副作用が消えていました。

チャネルの分解は不要で、そのまま処理ができます。

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスターまたご質問ください!

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスターよかったです。offsetが違うとおっしゃるようにムラになります。

フラット処理は割り算で演算します。

たとえばoffset 10でフラットを撮影したとき、 周辺減光の影響で明るい場所の値が110、暗い場所の値が60だったとします。

そうするとここからダークを引いた時にoffsetの10が引かれるので、フラットマスターの明るい場所が100、暗い場所が50となります。フラット処理は上述のように割り算ですので、明るい場所と暗い場所で100:50 = 2:1の割合で割られて、周辺減光のあった画像が均質になります。

もしoffset 20のダークで間違えて引いてしまうと、明るい場所が90、暗い場所が40となります。そうすると明るい場所と暗い場所の比率が2:1とならず(2.25:1になります)、割り算の演算をするとムラになってしまうわけです。

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスター岡村さん

こんにちは。

光害もありそうですが、フラットが合っていないようにも見えます。

通常のフラットは周辺減光だけになりますが、光害カットフィルターはフラットにムラが出ることが多いので、フラットが合っていないとこのように模様が出ることあるように思います。

丹羽

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスターおお、よかったです。またご質問ください!

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスター金岩さん

こんにちは。このエラーは十分な星が認識されないときに発生します。

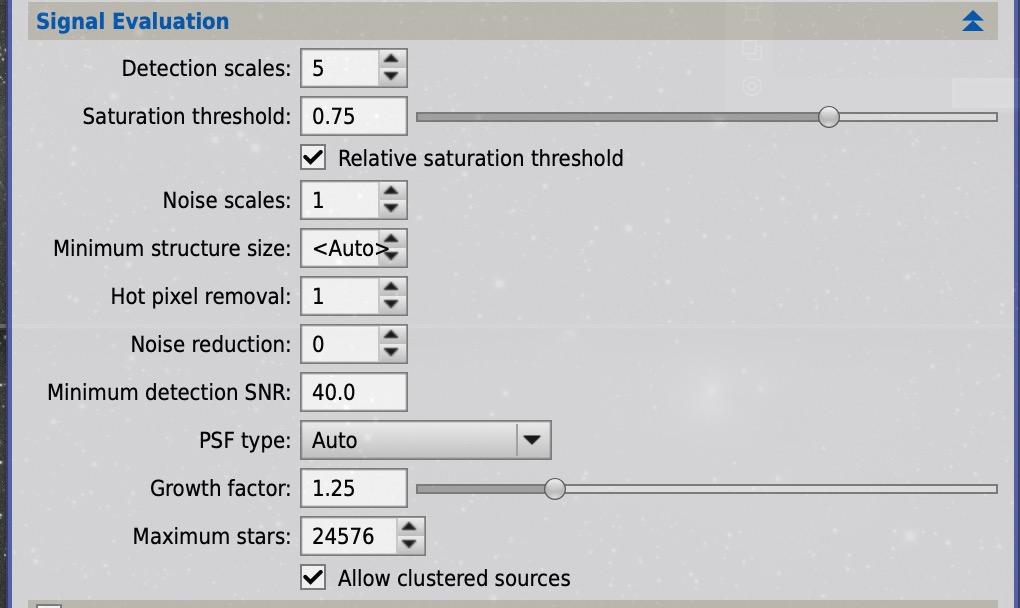

まずはSignal Evaluationの値をいろいろ変えて試してみてください。たとえば次を試してみてくださいますか。

Noise Redutionを0から5にする

Minimum detection SNRを40から10にするエラーが出た時も、エラーメッセージが変わったかなどお教えください。

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスター岡本さん

雑誌投稿の場合は「FSQとVSDをブレンド」と記載して、ブレンド比率は記載しなくても良いと思います。というのもナローバンドの画像などもブレンド比率などは皆さんともかかれていないためです。星沼会で合作したときも記載しませんでした。でも「FSQ 60%、VSD 40%でブレンド」などと記載されると、より親切な気もします!

Pixel Rejectionは画像単位ではなくて、ピクセル単位の排除です。これは人工衛星の軌跡や、星像で長細くなったピクセルなど、ピクセル単位で他の画像と違うピクセルを排除します。たとえば50枚の画像をピクセル毎に比較して1枚だけ人工衛星が写っていたら、そのピクセルは排除されます。異なる鏡筒でブレンドしたときに、この機能の副作用が出ないか心配しました。一方で、FSQもVSDも同じくらいの枚数があるならば、まったく気にしなくても良いようにも思い始めました。ちょっと私がコンサバだったかもしれません・・・

案外、一緒のインテグレーションもうまく行ってしまうかもしれません。もしうまくいけば、Pixel Mathよりも高品質になる可能性もありますね。もし試されたら、結果をお教えいただきたいです!

また実行するなかでわからないことがあれば、お気軽にご連絡ください(今回のように回答を失念していたら、プッシュください)。

丹羽

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスターこの件、回答していませんでした。遅くなってごめんなさい。

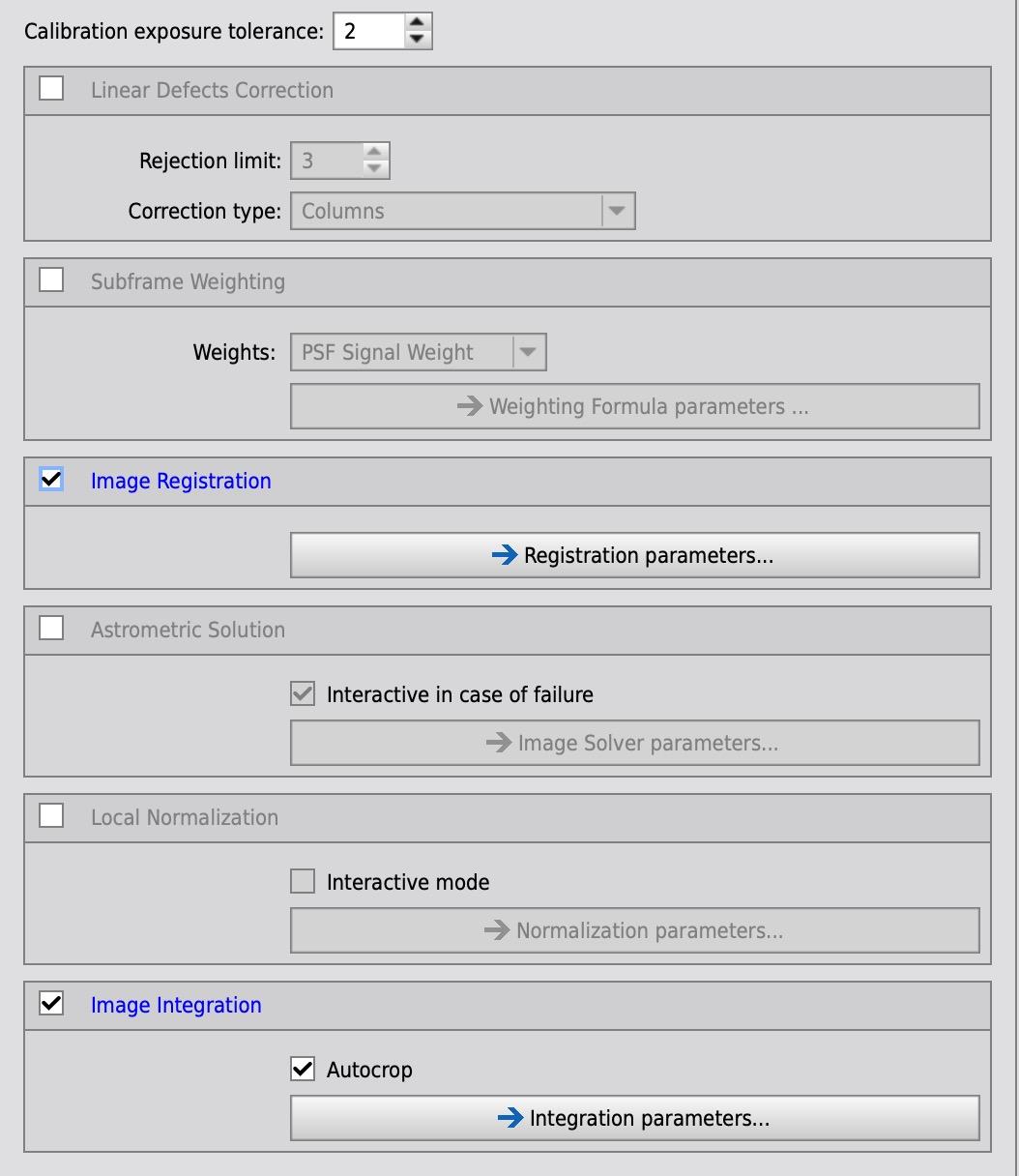

キャリブレーションをした後にインテグレーションする場合は、下記の画像のようにRegistrationとIntegrationにチェックします。鏡筒が違うのでLocal Normalizaitonはオフにした方が良さそうです。またAstronomic Solutionもオフにしてください。

ただ鏡筒が異なるためピクセルの状況がかなり違うので、Pixel Rejectionなどのプロセスで意図せずピクセルが除外されてしまう可能性があり、私はやったことがなく、あまりおすすめの方法とは言えないです。とはいえ一度、試してみてください!

別スレッドで質問された総露光時間が加味されるかどうかについてですが、下記の通りです。

◾️WBPPでインテグレーションする方法

この方法であれば露光時間による品質の良さは加味されます。◾️Pixel Mathでインテグレーション済みのファイルを合成する方法について

上記のPixelMathの計算式は単純に足して2で割っているので加味されません。もし差をつけたい場合は自分で調整します。たとえばFSQを60%、VSDを40%加える場合は、次のように記載します。FSQ*0.6 + VSD_registered*0.4

しかし経験上は、よほど画像のクオリティに差がない限り、足して2で割ることで十分効果はありました。

◾️APPについて

またAPPの方法ですが、私はインテグレーション目的ではやったことがないのです。やった方に聞くと、モザイクの方法と同じそうです。APPによるモザイクの方法は蒼月城さんのYouTubeで解説されていました。また、まとめですがインテグレーションは私は次の方針でやっています。

・同じ鏡筒・カメラの場合は、WBPPによるインテグレーション

・異なる鏡筒や異なるカメラの場合は、それぞれマスターを作ってPixel Mathで合成WBPPのインテグレーションは、Pixel Rejectionなどの処理が走るので、異なる鏡筒やカメラに使うとよろしくないだろう、と考えるのが理由です。

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスターFSQとVSDという鏡筒で思い出しました。先日、ご質問をいただいた件ですね。

いま前回のやりとりを拝見したら、最後の質問に対して回答がしていませんでした。ごめんなさい!

後から見やすいように前回のやりとりに対してコメントしますね。

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスターありがとうございます。もう一つ書き忘れました。撮影鏡筒はそれぞれ何でしょうか。

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスター岡本さん

ご質問をありがとうございます。

異なるカメラといった場合に、どんなカメラの画像を合成されようとされていますでしょうか。どれくらい異なるかによって、より良い方法は変わりますので、お教えください。

Masahiko Niwa/丹羽雅彦キーマスター

Masahiko Niwa/丹羽雅彦キーマスター新野さん

解決してよかったです。またお気軽にご相談ください。

丹羽

-

投稿者投稿